Par Haas Avocats

Alors qu’OpenAi dévoilait son intelligence artificielle (IA) générative et irradiait la planète, une certaine crainte a rapidement gagné le monde des nouvelles technologies.Face à ces craintes et à l’absence de réglementation, certaines personnalités ont signé un appel à mettre en pause le développement de l’IA tandis qu’une réflexion était lancée pour voir émerger des nouvelles règles éthiques à la manière des trois lois de la robotique d’Isaac Asimov.

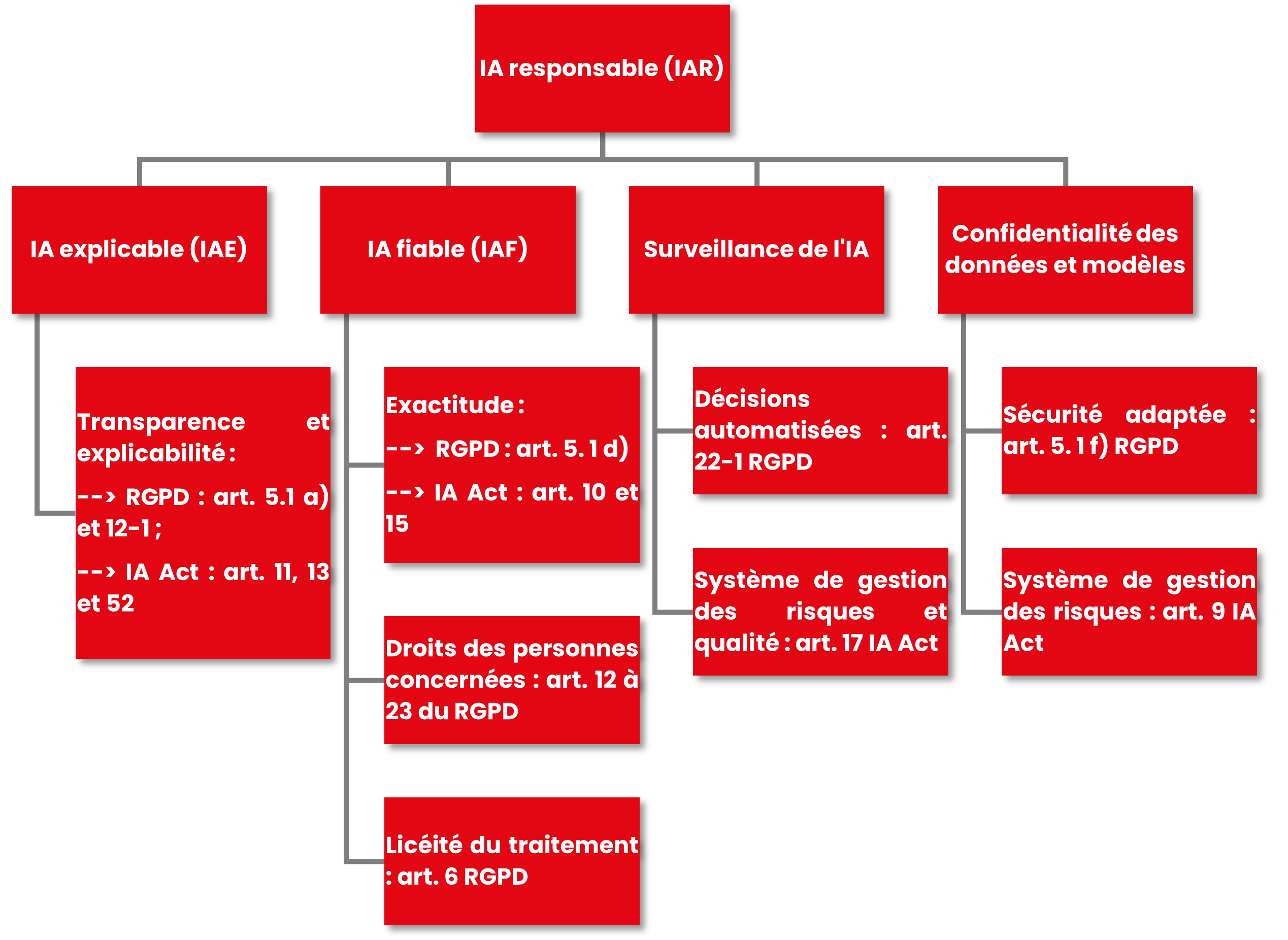

Ces règles nouvelle se retrouvent sous le concept « d’IA responsable (IAR) ».

L’IAR est composée de quatre piliers :

- l’IA fiable,

- l’IA explicable,

- la surveillance de l’IA

- la confidentialité des données.

C’est précisément sur la base de ces règles non contraignantes que le législateur européen a entamé la construction d’un cadre juridique avec son IA Act qui touche tous les domaines dans lesquels l’IA a vocation à intervenir.

En attendant, certaines législations telles que le règlement n°2016/679 du 27 avril 2016 dit Règlement Général sur la Protection des Données (RGPD) sont déjà applicables. Il importe alors aux développeurs d’IA de savoir que la machine juridique est en route. Si le train n’est pas pris en route, cette machine imposer une mise en conformité forcée qui risque de mettre à mal financièrement les start-ups prometteuses et couper court à leurs ambitieux projets.

Dans une logique anticipative, il apparait stratégique pour tous les développeurs, producteurs, distributeurs et utilisateurs d’IA de déployer une démarche de conformité tenant compte non seulement de cette évolution réglementaire mais également des règles juridiques préexistantes que sont par exemple le RGPD en matière de protection des données, le droit d’auteur et des producteurs de base de données ou encore le droit de la concurrence.

L’IAR s’inscrit pleinement dans cette logique anticipative qui n’est pas sans rappeler le principe d’éthique « by design » issue notamment de réflexions du Conseil d’Etat fin août 2022.

Répondre au besoin de confiance dans l’IA apparaît ici de manière prégnante tout en justifiant pleinement chacun de fondements de l’IA Responsable.

Définition de l’IA responsable ?

Cette confiance dans l’IA Responsable passera forcément par la protection des personnes contre le traitement illégal de leurs données personnelles par exemple du fait de de cybers attaques (fuite de données) ou de comportements inadéquats dans les relations de travail (vol de données, surveillance des salariés etc.).

De même, et d’un point de vue purement économique, il sera impossible de rechercher la confiance d’une personne sur quelque chose qu’elle ne comprend pas. Le RGPD comme l’IA Act, contiennent des dispositions destinées à répondre à ces besoins de sécurisation juridiques.

De fait, l’IAR s’inscrit dans cette logique par ses quatre volets :

L’IA explicable (IAE) :

L’IA est confrontée à la problématique des « boîte noire » (black box). Le processus de décision basé sur cette technologie est complexe à expliquer. Or, le RGPD prévoit un principe de transparence et l’IA Act imposera de mettre à disposition des utilisateurs une notice d’utilisation.

A ce titre, pour se conformer à ces règlements, les start-ups et les adeptes de l’IA devraient utiliser l’IAE.

Cela est d’autant plus important si l’IA en question est destinée au secteur de la santé. En effet, pour pouvoir recourir à une IA pour des actes de soins ou de diagnostic, le professionnel de santé doit pouvoir expliquer le fonctionnement de l’algorithme, ses paramètres et les conséquences.

Avec l’entrée en vigueur de l’IA Act, il en sera de même pour tous les systèmes d’IA considérés comme « à haut risque ».

L’entrepreneur devra ainsi s’efforcer d’ajouter des mécanismes permettant d’expliquer les décisions suggérées par un système d’IA. Rendre la « boîte noire » transparente ne répond pas forcément aux objectifs de l’IAR. Cet effort permettra de gagner la confiance des utilisateurs mais aussi de leur permettre de l’utiliser dans le cadre de leurs activités professionnelles.

L’IA fiable (IAF) :

La fiabilité renvoie à la question du fonctionnement même de l’IA et à ces biais éventuels. Un système d’IA de recrutement biaisé par des indicateurs de performance valorisant un type de profil particulier pourrait par exemple avoir pour effet de renforcer des inégalités et autres discriminations.

Cette problématique est notamment liée à la qualité des jeux de données alimentant Le système en question. A titre d’exemple si un système d’IA générative d’images venait à apparaître comme biaisé, c’est par exemple parce que ce système s’appuie sur une banque d’images stéréotypées.

Sur ce point observons que le RGPD impose un principe d’exactitude des données selon lequel les données traitées doivent être exactes et tenues à jour. L’IA Act prévoit également que les systèmes d’IA « à haut risque » devront satisfaire à des critères de qualité spécifiques. En particulier, ces jeux de données devront être pertinents au regard de la destination de l’IA, représentatifs, exempts d’erreurs et complets. La chasse aux biais et autres hallucinations devra être documentée.

La surveillance de l’IA et la confidentialité des données et des modèles :

Par leur capacité d’apprentissage autonome, l’IA implique une surveillance continue ainsi qu’une gestion des risques et de la qualité tout au long de son cycle de vie. Dans le cas contraire, l’entrepreneur s’expose à ce que son système perde en pertinence, voire à ce qu’il devienne une cible privilégiée des cyber criminels.

Il importe d’anticiper et de tenir compte de la capacité des pirates informatiques à inverser les modèles d’IA pour trouver les données d’entraînement.

Si le RGPD prévoit d’ores et déjà de mettre en œuvre les mesures techniques et organisationnels permettant un niveau de sécurité adapté, l’IA Act impose d’introduire des systèmes de gestion des risques et de la qualité.

En outre, cette surveillance est également liée à l’encadrement du RGPD à propos des décisions automatisées. En effet, les décisions fondées uniquement sur l’IA sont interdites sauf s’il y’a une intervention humaine. Cette intervention implique la supervision active de la décision automatisée. Avec la modération humaine, nous serons alors dans une prise de décision de nature hybride qui permettrait une mise en conformité avec le RGPD.

Ainsi, l’entrepreneur qui met en place un système de surveillance et des mesures de sécurité aptes à assurer la confidentialité des données conformément à l’IAR entamera une démarche de mise en conformité. Outre cette conformité, ce système d’IA permettra une confiance accrue du public.

Le RGPD propose ainsi des outils efficaces pour l’entrepreneur dans la mise en place de ces principes d’IAR ; principes qui se retrouvent également au sein de l’IA Act.

Il en est ainsi du recours à un délégué à la protection des données dont le rôle facilitera le respect des obligations de l’entrepreneur issues du RGPD et de l’IA Act. Celui-ci pourra aider à la réalisation d’une étude d’impact relative aux données personnelles. Cette étude aura notamment pour objectif de prévenir les risques d’un système d’IA ainsi que les mesures à mettre en place.

Schéma des liens entre l’IA responsable et la réglementation

***

Le cabinet HAAS Avocats est spécialisé depuis plus de vingt-cinq ans en droit des nouvelles technologies et de la propriété intellectuelle. Il accompagne les acteurs du numérique dans leur conformité à la règlementation relative à la protection des données personnelles et plus généralement à l’ensemble de la règlementation applicable à l’intelligence artificielle. Pour nous contacter, cliquez ici.

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(65).png)

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(62).png)

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(60).png)

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(55).png)