Par Haas Avocats

Le recours croissant aux systèmes de reconnaissance faciale s’immisce progressivement dans notre vie, que ce soit dans nos téléphones, aux contrôles de passeport, aux guichets automatiques ou bien même dans la rue avec la vidéosurveillance.

Le règlement général sur la protection des données à caractère personnel (RGPD) définit la reconnaissance faciale comme une technique de traitement de données biométriques soit relatives « aux caractéristiques physiques, physiologiques ou comportementales d’une personne physique, qui permettent ou confirment son identification unique ».

Cette reconnaissance faciale est une technologie biométrique qui permet de reconnaître automatiquement une personne sur la base de son visage.

Ce procédé biométrique a deux fonctions :

Selon un rapport du National Institute of Standards and Technology (NIST), centre d’expertise affilié au gouvernement américain, les systèmes de reconnaissance faciale sont loin d’être fiables. Comme toute technologie, ces systèmes peuvent être faillibles.

En effet, il est relevé que les algorithmes développés identifient à tort les personnes asiatiques ou noires cent fois plus souvent que les personnes blanches.

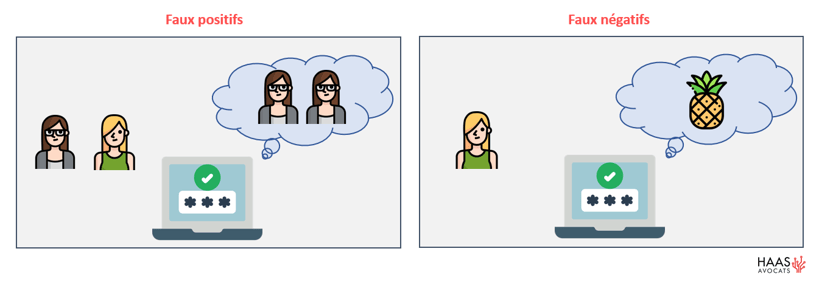

Il s’agit de 2 types d’erreurs :

Pour cette étude le NIST a étudié le fonctionnement de 189 algorithmes et utilisé une base de données contenant 18,3 millions d’images de 8,5 millions de personnes.

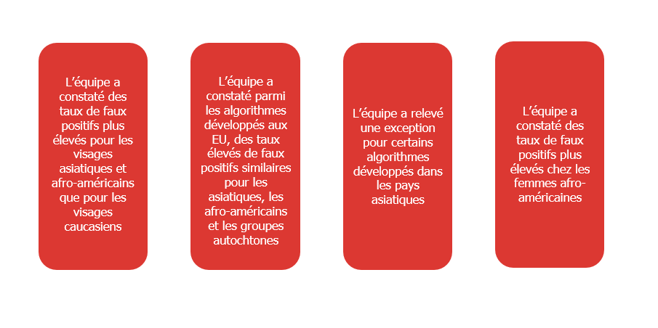

Certaines erreurs ont été relevées, notamment :

L’équipe du NIST a, toutefois, ajouté que tous les algorithmes ne donnent pas les mêmes taux élevés de faux positifs sur l’ensemble de la population. En effet, chaque algorithme a des performances différentes.

Toutefois, ces résultats sont alarmants car de faux positifs pourraient avoir de lourdes conséquences sur la population en fonction des domaines de mise en œuvre des systèmes de reconnaissance faciale.

A ce titre, une lettre a été adressée à Google, Amazon et Microsoft, en date du 15 janvier 2019, par 85 ONG américaines consacrées aux droits de l’homme et à la défense des libertés publiques, en leur demandant de ne pas vendre de système de reconnaissance faciale aux gouvernements pour qu’ils n’en fassent pas un mauvais usage.

En effet, se pose la question de savoir si de tels instruments doivent être utilisés par des personnes qui sont censées appliquer la loi.

Par ailleurs, ce constat conduit à s’interroger sur le danger des biais algorithmiques.

En effet, les algorithmes ont besoin de data pour pouvoir donner un résultat. En pratique, ces données sont intégrées dans la machine par un humain. Par conséquent, le résultat produit par un algorithme dépend de la manière dont les programmeurs les ont écrits.

Ainsi, si les développeurs ne prennent pas la précaution d’apprendre à leurs algorithmes à partir de données reflétant la réalité et se basant sur des principes de transparence et d’égalité, les systèmes de reconnaissance faciale pourront devenir dangereux.

En ce qui concerne la réalité, elle n’est d’ailleurs pas toujours rose … L’apprentissage des machines pourrait être l’occasion pour certains d’introduire de nouveaux principes et visions de voir le monde reposant sur des valeurs éthiques, humanistes, etc.

***

Le Cabinet HAAS Avocats, fort de son expertise depuis plus de 20 ans en matière de nouvelles technologies, accompagne ses clients dans différents domaines du droit, notamment en matière de protection des données personnelles. Si vous vous sentez concernés par le sujet de la reconnaissance faciale ou de l’intelligence artificielle d’une manière plus générale, n’hésitez pas à faire appel à nos experts pour vous conseiller. Contactez-nous ici

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(65).png)

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(62).png)

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(49).png)

.png?width=110&name=Neurotech%20%20au%20coeur%20de%20lesprit,%20aux%20fronti%C3%A8res%20du%20droit%20(48).png)